一个能解开物体视觉属性的节能引擎

大多数人天生就能够识别感官刺激的个体属性,例如他们看到的物体、他们听到的声音等等。虽然人工智能(AI)工具在识别图像或其他刺激物中的特定对象方面变得越来越好,但它们通常无法区分它们的个体属性(例如,它们的颜色、大小等)。

IBM苏黎世研究院和苏黎世联邦理工学院的研究人员最近开发了一种计算效率高的引擎,可以解读视觉刺激的不同属性。该引擎在NatureNanotechnology的一篇论文中介绍,最终可以帮助更快、更有效地解决复杂的现实世界问题。

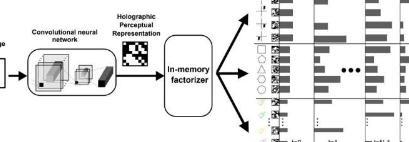

“我们一直致力于开发神经向量符号架构(NVSA)的概念,它在单一框架中提供感知和推理能力,”进行这项研究的研究人员之一阿巴斯·拉希米(AbbasRahimi)告诉TechXplore。“在NVSA中,视觉感知部分是由深层网络完成的,其中产生的表示以复杂的方式纠缠在一起,这可能适用于特定任务,但很难泛化到略有不同的情况。例如,纠缠表示‘红色小三角形’不能揭示物体的概念属性,如颜色、大小、类型等。”

为了克服现有NVSA架构的局限性,Rahimi和他的同事着手创建一个新引擎,可以解开图像中对象的视觉表示,分别表示它们的属性。这个引擎被称为“内存分解器”,它基于称为谐振器网络的递归神经网络的变体,它可以迭代地解决特殊形式的分解问题。

“在这种优雅的数学形式中,属性值及其纠缠通过高维全息矢量表示,”Rahimi解释道。“它们是全息的,因为编码信息均匀分布在矢量的所有组件上。在谐振器网络中,这些全息表示由矢量符号体系结构的运算符迭代操作以解决因式分解问题。”

谐振器网络是一种循环神经网络,旨在解决因式分解问题(即需要将一个整数拆分为更小的因子的问题,这些因子在相乘时会产生原始数字)。虽然谐振器网络已被证明可有效解决许多简单的因式分解问题,但它们通常有两个关键限制。

首先,这些网络很容易进入“无限搜索循环”,这种现象被称为极限环。此外,谐振器网络通常无法快速有效地解决涉及多个因素的大问题。Rahimi和他的同事创建的引擎解决并克服了这两个限制。

Rahimi说:“我们的内存分解器通过自然地利用固有忆阻设备噪声来防止谐振器网络陷入极限循环,从而丰富了模拟内存计算(AIMC)硬件上的谐振器网络。”“这种基于相变材料的固有设备随机性通过允许在每次迭代中执行噪声计算,将确定性谐振器网络升级为随机谐振器网络。此外,我们的内存分解器引入了基于阈值的非线性激活和收敛检测。”

作为他们最近研究的一部分,研究人员使用两个内存计算芯片创建了他们的引擎原型。这些芯片基于相变忆阻器件,有望成为既能执行计算又能存储信息的系统。

“实验性AIMC硬件设置包含两个相变存储器内核,每个内核具有256×256单位单元,用于执行矩阵向量乘法(MVM)和转置MVM,具有高度并行性和恒定时间,”Rahimi说。“实际上,我们的内存分解器将向量分解的计算时间复杂度降低到仅仅是迭代次数。”

在最初的评估中,Rahimi和他的同事创建的内存中因式分解器取得了非常有希望的结果,解决的问题至少是使用基于谐振器网络的传统系统可以解决的问题的五倍,也更复杂。值得注意的是,他们的引擎还可以更快地解决这些问题并消耗更少的计算能力。

“我们研究的一个突破性发现是AIMC硬件中不可避免的随机性不是诅咒而是祝福,”Rahimi说。“当与阈值技术相结合时,这种随机性可以为解决至少五个数量级的更大组合问题铺平道路,这些问题以前在给定的约束条件下是无法解决的。”

未来,由这组研究人员创建的新分解引擎可用于可靠地解开相机或其他传感器捕获的图像中物体的个体视觉属性。它还可以应用于其他复杂的分解问题,为人工智能研究开辟令人兴奋的新途径。

“我们的内存分解器加速了分解过程中涉及的大量计算量大的MVM操作,”Rahimi补充道。“接下来,我们正在寻求设计和测试能够执行更大MVM的大规模AIMC硬件。”

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。